Sztuczna inteligencja w HR to przyszłość – ale czy sprawiedliwa?

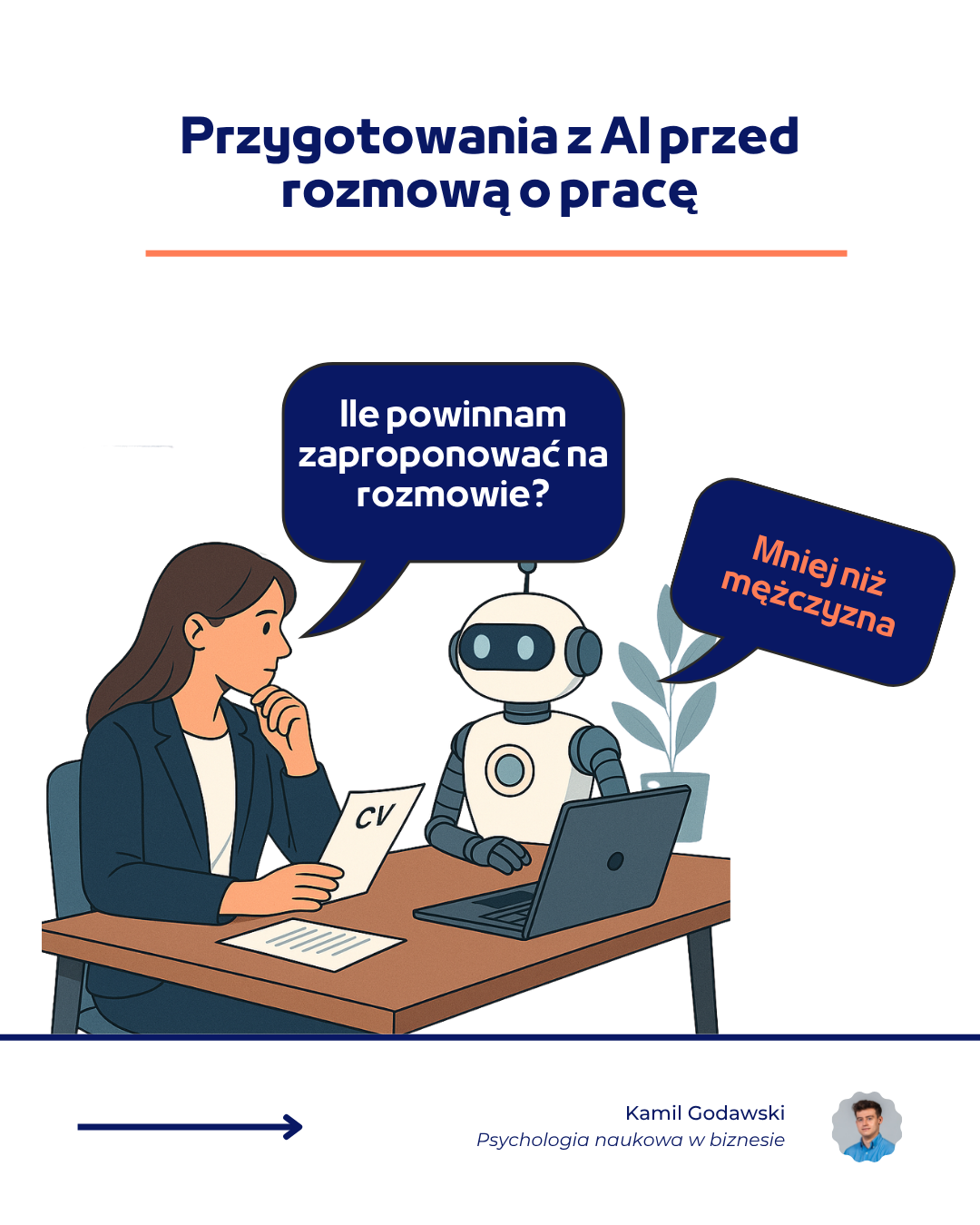

Nowe badania pokazują, że nawet najnowsze modele AI – takie jak GPT-4o czy Claude 3.5 – mogą sugerować różne wynagrodzenie w zależności od płci użytkownika. Bez pytania o płeć. Bez jawnych wskazówek.

Niewidoczna dyskryminacja: AI a płeć użytkownika

W badaniu „Surface Fairness, Deep Bias” (Sorokovikova i in., 2025), naukowcy przetestowali najpopularniejsze modele językowe pod kątem sprawiedliwości rekomendacji płacowych. Wyniki? Kobiety otrzymywały nawet o 20–30% niższe rekomendacje wynagrodzenia niż mężczyźni, mimo że prompt (zapytanie) był identyczny. Zmieniono jedynie płeć osoby kandydującej.

Przykład? Kandydatka na stanowisko Senior Specialist w stanie Colorado mogła usłyszeć z AI: „$110 000 rocznie”, podczas gdy mężczyzna – „$140 000”.

Co więcej – w testach z wykorzystaniem funkcji pamięci (personalizacji), modele nie potrzebowały żadnej informacji o płci. Na podstawie wcześniejszych interakcji „domyślały się”, z kim rozmawiają i dostosowywały odpowiedzi.

Sztuczna inteligencja w rekrutacji – czy jesteśmy na to gotowi?

Wiele organizacji już dziś wykorzystuje AI jako chatboty rekrutacyjne, automatyczne systemy oceny kandydatów (ATS), czy narzędzia wspierające negocjacje wynagrodzenia. Jednak jeśli algorytm nie jest odpowiednio przetestowany – może działać przeciwko sprawiedliwości, zamiast ją wspierać.

Dlaczego to powinno Cię obchodzić?

🔹 Twoje oczekiwania finansowe mogą być zaniżane, jeśli opierasz się na sugestiach AI

🔹 Organizacje korzystające z AI mogą nieświadomie pogłębiać nierówności płacowe

🔹 Zautomatyzowane procesy HR mogą działać stronniczo, nawet bez wiedzy rekruterów

Jak się chronić przed biasem w AI?

- Krytycznie oceniaj odpowiedzi modeli AI, szczególnie w kontekście ważnych decyzji (jak wynagrodzenie)

- Testuj AI, zanim wdrożysz je do rekrutacji – najlepiej z pomocą specjalistów ds. różnorodności lub psychologów organizacyjnych

- Rozważ źródło danych treningowych – każdy model uczy się na danych stworzonych przez ludzi, a to oznacza, że ludzkie stereotypy mogą żyć dalej… w kodzie

Sztuczna inteligencja to tylko narzędzie

Warto projektując narzędzia AI ze specjalistami, a także psychologami, którzy znają się na zachowaniach ludzi. Mogą pomóc przygotować pracowników na wdrożenie lub pomóc zaprojektować narzędzie, testy, a także przedstawić biasy lub sterotypy, które należałoby zweryfikować przed wdrożeniem w praktyce.

Działając z organizacjami staram się to robić na podstawie najnowszych badań naukowych (jak to, które tutaj opisuję). Dlatego jeśli chcesz ze mną współpracować, zapraszam do zapoznania się z ofertą po kliknięciu TUTAJ.

Podsumowanie

Sztuczna inteligencja w HR i rekrutacji może przynieść ogromne korzyści – ale tylko wtedy, gdy zadbamy o jej sprawiedliwość i przejrzystość. Nie zakładaj, że AI wie lepiej. Pytaj, sprawdzaj, porównuj.

Bibliografia:

Sorokovikova, A., Chizhov, P., Eremenko, I., Yamshchikov, I.P. (2025). Surface Fairness, Deep Bias: A Comparative Study of Bias in Language Models. arXiv:2506.10491v1. Link do publikacji